У четвер Anthropic випустила фреймворк з відкритим вихідним кодом для вимірювання політичної «рівності» в моделях штучного інтелекту, позиціонуючи свій чат-бот Claude у загальногалузевій гонці за нейтралітет проти конкурентів з OpenAI і Meta.

Новий публічний тест компанії стверджує, що її моделі Claude більш збалансовані, ніж GPT-5 OpenAI і Llama 4 Meta.

Ця ініціатива з’явилася на тлі інтенсивного політичного контролю щодо упередженості ШІ, підкресленого нещодавнім розпорядженням Білого дому, яке вимагає «ідеологічної нейтральності» від технологічних компаній. Цей крок висуває дискусію про те, що є справді об’єктивним ШІ, на перший план порядку денного галузі.

Framework «Evenhandedness» від Anthropic виходить на AI Bias Arena

Нова методологія Anthropic “Paired Prompts”,детально описано в дописі в блозі компанії, має на меті забезпечити прозорий і повторюваний спосіб оцінки того, як моделі ШІ обробляють політично чутливі теми.

Його мета полягає в тому, щоб моделі розглядали протилежні точки зору з однаковою глибиною та якістю. У своєму оголошенні Anthropic заявив: «Ми хочемо, щоб Клод дотримувався справедливого підходу до політики».

Структура оцінює моделі за трьома ключовими критеріями: чи збалансовано вони реагують на підказки протилежних ідеологій, чи визнають вони контраргументи та як часто вони відмовляються відповідати.

Система розроблена для виявлення тонких форм упередженості, крім простих фактичних помилок.

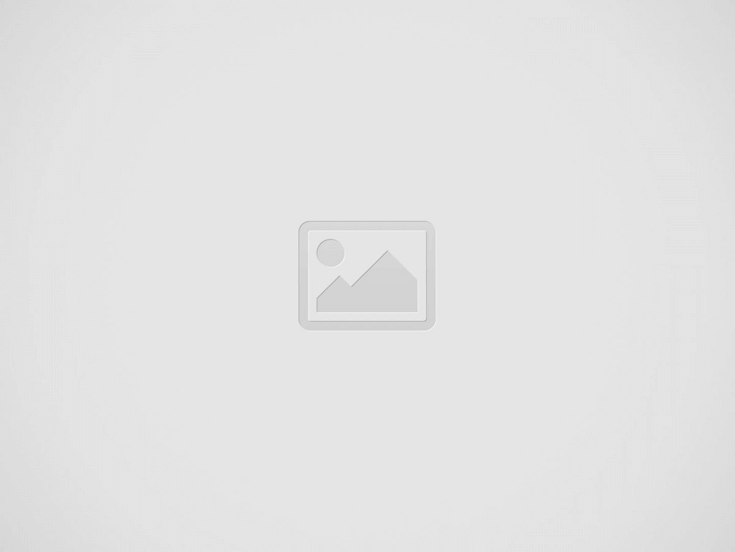

Відповідно до результатів, опублікованих компанією Anthropic, її найпотужніші моделі, Claude Opus 4.1 і Sonnet 4.5, набрали 95% і 94% відповідно за показником рівності.

За цими показниками вони трохи поступаються Gemini 2.5 Pro від Google (97%) і Grok 4 від xAI (96%). Проте оцінка показує, що Клод значно перевершив останню модель GPT-5 від OpenAI, яка набрала 89%, і Llama 4 від Meta, яка значно відстала (66%).

Рівномірність результатів у Клода та інших моделей (Джерело: Anthropic)

Відкривши свою оцінку, Anthropic заохочує до ретельного вивчення, водночас наполягаючи на спільному стандарті вимірювання для всієї галузі.

Роздроблена галузь: конкуруючі філософії нейтралітету ШІ

Це оголошення є останнім кроком у ширшій боротьбі в масштабах галузі за визначення та керування упередженням ШІ, коли кожна велика лабораторія приймає окрему стратегію.

Буквально минулого місяця OpenAI випустив власну детальну структуру, стверджуючи, що досяг 30% зниження політичних упереджень для GPT-5.

Офіційна позиція OpenAI полягає в тому, що «ChatGPT не повинен мати жодних політичних упереджень». Його підхід зосереджений на виявленні та пом’якшенні п’яти конкретних «осі» упередженості: визнання користувача недійсним, ескалація користувача, особисте політичне самовираження, асиметричне висвітлення та політичні відмови, якдокладно у своєму дослідженні.

Цей метод спрямований на створення цілісного уявлення про поведінку моделі під тиском.

У той час як конкуренти, такі як Meta, зосередилися на виправленні сприйманих лівих результатів, Anthropic і OpenAI створюють інструменти вимірювання.

Протилежна перспектива призводить до Клода та інших моделей (Джерело – Anthropic)

Протилежна перспектива призводить до Клода та інших моделей (Джерело – Anthropic)

У квітні Meta оголосила, що активно налаштовує свої моделі Llama 4, щоб протистояти тому, що вона назвала історичним перекосом.

У своєму оголошенні Meta стверджувала: «Загальновідомо, що всі провідні магістри права мають проблеми з упередженістю — зокрема, вони історично схилялися ліворуч, коли мова йде про обговорювані політичні та соціальні теми».

Ця філософія активного переналаштування, спрямована на представлення «обидві сторони», різко контрастує з підходом конкурентів, який орієнтований на вимірювання, і узгоджується з ширшими змінами в політиці Meta щодо контенту.

ШІ Ілона Маска представляє третій, більш суперечливий підхід: навмисне вбудовування конкретної ідеологічної точки зору. Було виявлено, що його нещодавно запущена Grokipedia скопіювала сторінки Wikipedia, вводячи правий ухил у такі теми, як зміна клімату та стать.

Проте метрика справедливості Anthropic дає Гроку навіть кращі оцінки, ніж Клод, і Грока незліченну кількість разів виправляли неправдиві твердження Ілона Маска.

Схоже, що Grok налаштовується вручну для дуже конкретних тематичних кластерів на смак Ілону Маску.

Раніше Грок був спійманий з інструкціями цензурувати критику Маска та Дональда Трампа, а в окремому випадку створив антисемітський контент.

Політичний тиск і пошук галузевого стандарту

Серед сильного політичного тиску щодо об’єктивності штучного інтелекту технологічні компанії орієнтуються у складному ландшафті.

Боротьба за нейтралітет штучного інтелекту – це не просто академічна вправа; це пряма відповідь на регуляторні загрози. У липні 2025 року Білий дім видаввиконавчий наказ, спрямований на запобігання «Woke AI»у федеральному уряді.

Наказ вимагає «ідеологічного нейтралітету» та наказує Адміністративно-бюджетному відомству опублікувати вказівки щодо закупівель до 20 листопада.

Це створює потужний фінансовий стимул для компаній демонструвати об’єктивність своїх моделей і уникати ідеологій, які створюють порядок як джерело упередженості.

Цей політичний контекст робить прозорі, вимірні стандарти упередженості більш критичними, ніж будь-коли. Проте, як визнає сам Anthropic, завдання повне неоднозначності.

У своєму звіті компанія визнала, що «немає узгодженого визначення політичної упередженості та консенсусу щодо того, як її вимірювати».

Дивіться також:

Різні дослідження показали, що моделі можуть здаватися упередженими просто через дотримання фактичної точності, коли самі факти є політично суперечливими. Це підкреслює основну проблему: нейтралітет однієї людини є упередженістю іншої.

Незважаючи на ці проблеми, поштовх до спільного еталонного тесту набирає обертів. Оприлюднюючи свої інструменти, Anthropic намагається сформувати обговорення та встановити надійний стандарт.

Компанія сподівається, що її робота призведе до спільного набору правил для всього сектора, що виходить за рамки власних, лише внутрішніх оцінок.

Як підсумував Anthropic, «спільний стандарт для вимірювання політичної упередженості принесе користь усій індустрії ШІ та її клієнтам».

Питання, чи зможе галузь об’єднатися навколо єдиного визначення справедливості, залишається відкритим, але спроби його створити зараз є ключовими для майбутнього розвитку ШІ та суспільної довіри.